Roboter sind derzeit nicht in der Lage, in unterschiedlichen Situationen optimal auf Menschen einzugehen. Um das zu ändern, wenden Forschende das Prinzip der Ko-Konstruktion an. Damit wollen sie Maschinen neues Wissen und Fähigkeiten in einer Weise vermitteln, die für Menschen natürlich ist: Mensch und Maschine arbeiten zusammen, um ihre Umwelt zu interpretieren und Handlungen auszuführen. Drei Bielefelder Wissenschaftlerinnen stellen vor, wie sie sich in ihren Projekten der Ko-Konstruktion widmen.

Sprachmodelle sollen verstehen, was wir sagen und sehen

Dr. Sina Zarrieß ist Professorin für Computerlinguistik in der Fakultät für Linguistik und Literaturwissenschaft.

„Spontane situierte Dialoge zwischen Gesprächspartner*innen funktionieren auf vielen sprachlichen Ebenen völlig anders als geschriebene Texte. Wenn man zum Beispiel jemanden erklären möchte, wie man einen kaputten Fahrradschlauch repariert, ist das wesentlich einfacher, wenn man gemeinsam vor dem Fahrrad steht, als wenn man das Gleiche in einer E-Mail erklären muss. Das liegt an den sprachlichen und kommunikativen Mitteln, die in der Situation verwendet und kombiniert werden können. Beide Gesprächspartner*innen können den Fahrradschlauch sehen und manipulieren. Sie können etwas vormachen. Sie können zum Beispiel direkt auf Aktionen des*der anderen reagieren und diese korrigieren, Rückfragen stellen und unterbrechen. Dieses interaktive Ko-Konstruieren von Handlungen, Instruktionen und Erklärungen ist mit heutigen Dialogsystemen, virtuellen Agenten und Robotern fast unmöglich. Denn es erfordert Modelle und Methoden des Maschinellen Lernens, die Sprach- und Bildverarbeitung oder auch Modellierung von Bewegungen und Handlungen eng verknüpfen. Um Ko-Konstruktion in Dialogen mit Maschinen zu ermöglichen, erforschen wir in der Computerlinguistik Sprachmodelle, die auch mit bildlichen Daten arbeiten. Sie sollen etwa Objekte oder Handlungen auf Bildern und in Videos beschreiben können. Dafür müssen sie bisher Assoziationen zwischen Bild und Sprache aus riesigen Datensätzen lernen und können den Lernprozess kaum an Feedback eines menschlichen Gegenübers anpassen. Eine große Herausforderung ist es außerdem, diese Systeme in Echtzeit-Interaktionen in dynamischen Situation einzusetzen.“

© Norma Langohr

Verständnis-Monitoring soll inklusiv und fair sein

Dr. Hanna Drimalla ist Professorin für Multimodale Verhaltensverarbeitung in der Technischen Fakultät und leitet ein Projekt im Transregio „Erklärbarkeit konstruieren“ (SFB/TRR 318).

„Ein Erklärprozess funktioniert immer zweiseitig. Wer etwas gezielt erfolgreich erklären möchte, ist darauf angewiesen, vom Gegenüber Rückmeldung zu erhalten, wie sie oder er etwas verstanden hat. Ein Mensch erklärt etwas, überwacht gleichzeitig, ob das Gegenüber die Erklärung versteht und wie es darauf reagiert, und passt die Erklärung aufgrund dieser Informationen direkt im Gespräch an. Im TRR 318 sollen auch Maschinen Erklärungen liefern, die sie mit ihren Nutzer*innen gemeinsam generiert. In unserem Teilprojekt A06 im TRR 318 wollen wir eine Lösung dafür finden, die menschlichen Reaktionen für die KI erfassbar zu machen. Die Bandbreite an Einflüssen, die auf menschliche Reaktionen einwirken und diese verändern können ist groß. Für jede Form von psychischer Störung und jede Situation ein eigenes Modell zu konstruieren, wäre daher nicht praktikabel. Stattdessen wollen wir es dem einzelnen Menschen ermöglichen, den Verstehensprozess gemeinsam mit der Maschine zu entwickeln. Für unsere Modelle zum Erkennen von Verständnis beim Menschen nutzen wir zum Beispiel die automatische Erkennung von Gesichtsausdruck, Blickverhalten und Stimmlage aus Videodaten. Unser Ziel sind Modelle, die den Nutzer*innen direkt zurückspiegeln, warum die Maschine bei der jeweiligen Person Verständnis oder Unverständnis erkannt hat. So wird erreicht, dass dieses Verständnis-Monitoring inklusiv und fair ist. Es soll für jeden Menschen und auch über Situationen hinweg funktionieren.“

© Mike-Dennis Müller

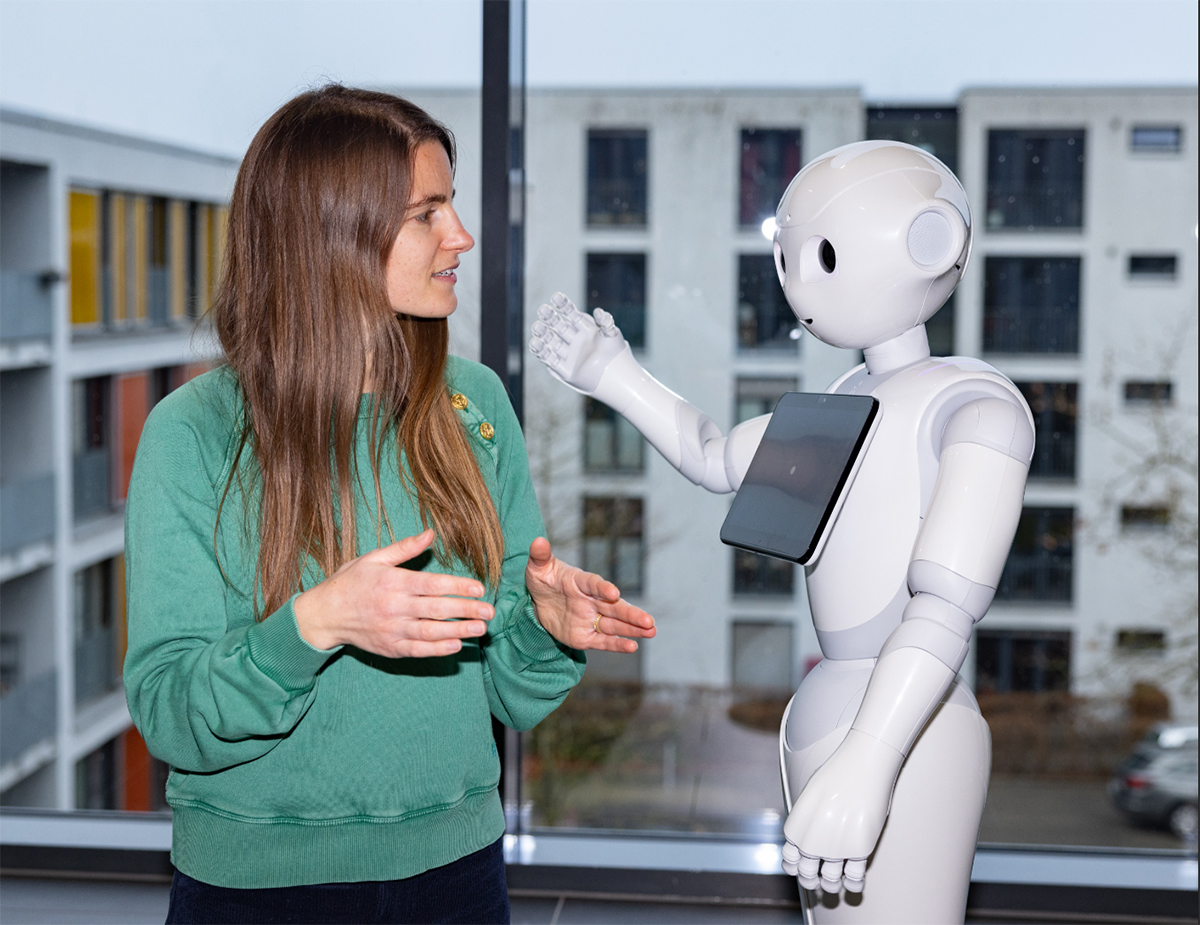

Bei Irrtümern die Funktionsweise des Roboters visualisieren

Dr. Anna-Lisa Vollmer forscht in der Arbeitsgruppe Medizinische Assistenzsysteme der Medizinischen Fakultät OWL und leitet ebenfalls ein Projekt im TRR 318.

„Mit den wachsenden technischen Möglichkeiten wachsen auch die Einsatzgebiete von künstlichen Intelligenzen wie Robotern. Außerdem steigt die Komplexität dieser Systeme und parallel schwindet die Möglichkeit für Nicht-Expert*innen, die Funktionsweise dieser zu erfassen. Im TRR 318 werden diese Probleme für Künstliche Intelligenz mit dem Fokus auf- Erklärungen angegangen – und das für verschiedenste Anwendungsfelder und Fachbereiche. In meinem Teilprojekt B05 widmen wir uns der Assistenzrobotik. Solche Systeme sollten von jeder und jedem in individuelle Aufgaben einweisbar sein. Dafür müssen die Roboter von Menschen lernen können, die sich nicht mit ihrer Funktionsweise auskennen. Hierbei kann ein mangelndes Verständnis jedoch dazu führen, dass dem Roboter die Aufgaben in einer für diesen ungeeigneten Weise beigebracht werden. Die Interaktion bricht in diesen Fällen ab, der Roboter lernt langsam oder gar nicht. In unserem Teilprojekt wollen wir deshalb Methoden entwickeln, die während des Lernprozesses das Verständnis der Nutzer*innen einschätzen, um gezielt mit Visualisierungen der Funktionsweise des Roboters zu unterstützen. Durch die Einblendungen können problematische Wissenslücken gefüllt und Missverständnisse korrigiert werden. Besonders herausfordernd ist bei dieser Ko-Konstruktion das Erkennen der Auffassung im Menschen und die Auswahl der relevanten Information, die erklärend dargestellt wird.“

© Mike-Dennis Müller

Die Zitate wurden von Dr. Kristina Nienhaus aufgezeichnet.